Nuxeo-Plattform

Die cloudnative und auf Low Code basierte Nuxeo-Plattform ist Ihre Geheimwaffe für die Anwendungsentwicklung mit schneller Bereitstellung und zur Unternehmensmodernisierung in der Cloud.

Hauptmerkmale

Werfen Sie einen Blick auf einige zentrale Funktionen der Nuxeo-Plattform, die Sie bei der Bewältigung der schwierigsten aktuellen und zukünftigen Herausforderungen unterstützen.

Cloudnative Plattform

Die Nuxeo-Plattform funktioniert ganz nach Ihren Anforderungen und wo Sie es möchten. Schützen Sie Ihre Informationen mit einer Cloud-First-Plattform, der einige der weltweit größten Unternehmen vertrauen.

Anpassungsfähige künstliche Intelligenz

Nuxeo Insight bietet intelligente Vorhersagen, ohne dafür ein Team von Datenanalysten zu benötigen. Die künstliche Intelligenz ist unternehmensspezifisch und mit nur wenigen Klicks aufrufbar.

Skalierbarkeit und Leistung

Die modulare Cloud-First-Architektur lässt sich horizontal und unabhängig skalieren und passt sich selbst größten Arbeitslasten in Echtzeit an, um Höchstleistungen zu erbringen.

Suche

Die Nuxeo-Plattform liefert die Ergebnisse einfacher und erweiterter Suchabfragen blitzschnell (<20 ms), selbst unter hoher Auslastung.

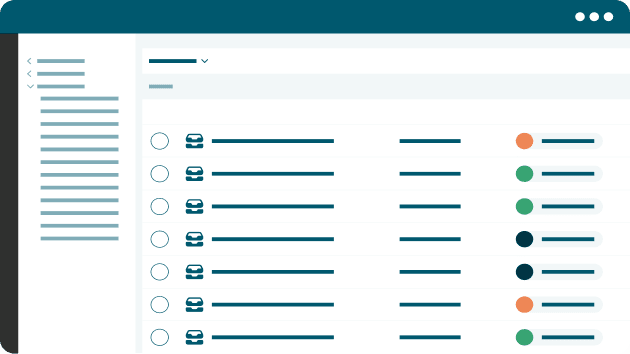

Workflows

Workflow-Management- und Automatisierungssysteme können die Geschäftseffizienz liefern, die Unternehmen heute benötigen, um wettbewerbsfähig zu bleiben.

Erweiterbarkeit

Die Nuxeo-Plattform verfügt über ein umfassendes, dokumentengesteuertes REST zum Erstellen, Abfragen und Verwalten einer befehlsorientierten API für komplexe Content-Interaktionen.

Nuxeo-Plattform kennenlernen

Profitieren Sie von trainierbarer künstlicher Intelligenz (KI), modularer Architektur und Cloud mit einer Low-Code-Entwicklungsumgebung – um Ihren Teams wieder die Kontrolle über Ihre Inhalte und Informationen zu geben.

Integrationen

Integrationen der Nuxeo-Plattform

Die Federation-Funktionen der Nuxeo-Plattform verbinden Informationssysteme im Unternehmen, sodass alle Unternehmensinformationen zentral abgerufen werden können – eine Möglichkeit zur Optimierung Ihres Informationsmanagements.