Nuxeo

Créée pour le cloud et low-code, la plateforme Nuxeo est votre arme secrète de déploiement rapide pour le développement d'applications et la modernisation de l'entreprise dans le cloud.

Fonctionnalités principales

Découvrez quelques-unes des fonctionnalités clés de la plateforme Nuxeo qui vous aideront à relever les défis les plus difficiles d'aujourd'hui et de demain.

Plateforme cloud native

Nuxeo Platform fonctionne comme et où vous le souhaitez. Protégez vos informations grâce à une plateforme axée sur le cloud à laquelle font confiance les plus grandes entreprises du monde.

IA adaptable

Nuxeo Insight permet de faire des prédictions plus pertinentes sans avoir recours à une équipe d'experts en données. L'intelligence artificielle propre à l'entreprise n'est qu'à quelques clics.

Extensibilité et performance

L'architecture modulaire, axée sur le cloud, évolue horizontalement et indépendamment, s'adaptant aux charges de travail les plus lourdes en temps réel pour offrir des performances élevées.

Recherche

La plateforme Nuxeo fournit très rapidement des résultats de recherche simple ou avancée (moins de 20 ms), même en cas de charge importante.

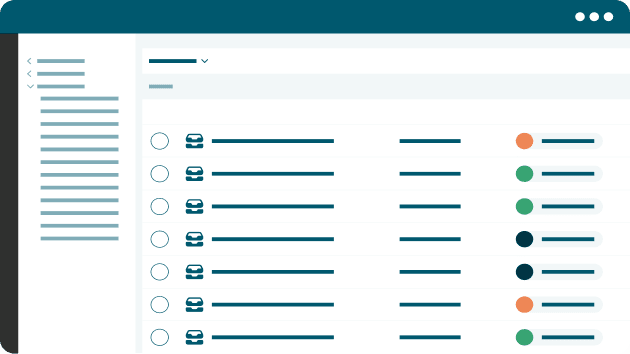

Workflows

Les systèmes de gestion et d'automatisation des workflows peuvent apporter aux entreprises d'aujourd'hui les améliorations dont elles ont besoin pour rester compétitives.

Extensibilité

La plateforme Nuxeo dispose d'une architecture REST complète, orientée document, pour créer, interroger et gérer une API axée sur les commandes pour des interactions complexes avec le contenu.

Découvrir la plateforme Nuxeo

Profitez de l'IA entraînable, de l'architecture modulaire et du cloud, avec un environnement de développement low-code, pour redonner à vos équipes le contrôle de vos contenus et de vos informations.

Intégrations

Intégrations de la plateforme Nuxeo

Les fonctionnalités de fédération de la plateforme Nuxeo connectent les systèmes d'information de votre entreprise afin de fournir un hub central pour toutes les informations et un moyen d'optimiser votre technologie de gestion de l'information.